OpenAI presenta nuevos modelos de IA de peso abierto: GPT-OSS

Después de más de cinco años centrados en modelos cerrados como GPT-3, GPT-4 y sus versiones empresariales, OpenAI acaba de dar un giro inesperado: ha lanzado GPT‑OSS, una nueva familia de modelos de lenguaje de peso abierto (open-weight) que cualquier persona o empresa puede descargar, estudiar y adaptar a su entorno.

Este movimiento marca un antes y un después en la industria de la inteligencia artificial, especialmente considerando que la compañía había mantenido una postura reservada frente al código abierto desde GPT-2 en 2019.

GPT-OSS

GPT‑OSS (Open Source Series) es una línea de modelos de lenguaje generativo basada en la arquitectura Mixture-of-Experts (MoE), diseñada para ser eficiente y versátil.

OpenAI ha lanzado dos versiones principales:

🟢 GPT‑OSS‑20B

-

Tamaño: ~21 mil millones de parámetros

-

Memoria mínima requerida: 16 GB

-

Ideal para: Desarrolladores individuales, proyectos locales, edge computing

🔵 GPT‑OSS‑120B

-

Tamaño: ~117 mil millones de parámetros

-

Memoria recomendada: 80 GB de VRAM

-

Ideal para: Empresas, laboratorios de investigación, soluciones cloud privadas

Ambos modelos están disponibles bajo licencia Apache 2.0, lo que permite su uso comercial y modificaciones sin restricciones legales complejas.

Estos modelos superan a otros modelos abiertos de tamaño similar en tareas de razonamiento, muestran buenas capacidades de uso de herramientas y están optimizados para la implementación eficiente de hardware de consumo. Fueron entrenados con una combinación de aprendizaje por refuerzo y técnicas inspiradas en los modelos internos más avanzados de OpenAI, incluido o3 y otros sistemas de vanguardia.

Incorporan medidas de seguridad robustas validadas por expertos externos y cumplen con altos estándares similares a los modelos cerrados de OpenAI. Han sido probados por socios como Orange, Snowflake y Al Sweden, quienes ya los aplican en entornos de datos sensibles. Esta iniciativa marca un avance importante hacia la democratización de la IA, permitiendo que desarrolladores, empresas y gobiernos ejecuten y personalicen modelos de lenguaje avanzados en su propia infraestructura.

¿Qué lo hace diferente?

Los modelos GPT‑OSS fueron entrenados con las técnicas más avanzadas de OpenAI, priorizando el razonamiento, la eficiencia y su aplicabilidad en entornos reales. Aunque OpenAI ya había liberado modelos como Whisper y CLIP, estos son sus primeros modelos de lenguaje open-weight desde el lanzamiento de GPT-2. Ambos modelos están basados en la arquitectura de transformers con mezcla de expertos (MoE), lo que permite activar solo una parte de sus parámetros en cada operación, optimizando el rendimiento.

El modelo GPT‑OSS‑120B utiliza 5.100 millones de parámetros por token, mientras que el 20B usa 3.600, aunque el total de parámetros es de 117B y 21B, respectivamente. Incorporan técnicas como atención densa y dispersa, atención de múltiples consultas agrupadas, y codificación posicional RoPE, lo que les permite manejar contextos de hasta 128.000 tokens. Fueron entrenados con datos de alta calidad en inglés, centrados en ciencia, tecnología, programación y cultura general, y utilizan un tokenizador mejorado llamado o200k_harmony, que también está disponible como código abierto.

A diferencia de los modelos cerrados que funcionan solo a través de API y requieren conexión a servidores externos, GPT‑OSS puede instalarse en local, dándote:

-

Control total sobre tus datos

-

Baja latencia en generación

-

Ajustes personalizados

-

Despliegue offline o en servidores privados

Además, están optimizados para tareas complejas como:

-

Razonamiento lógico (chain-of-thought)

-

Generación de código

-

Instrucciones multimodales

-

Respuestas en lenguaje natural

Entrenamiento de GPT-OSS

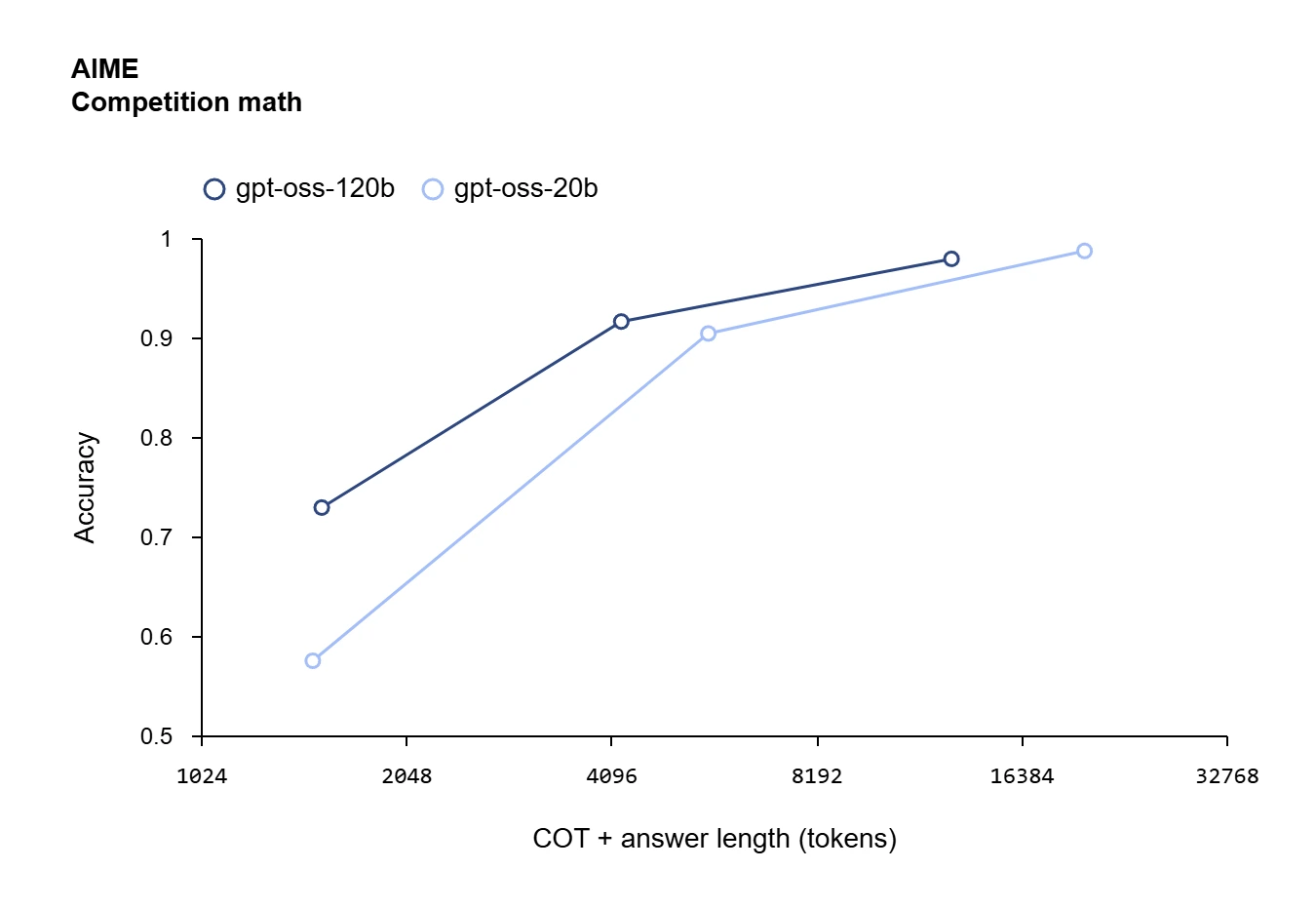

Los modelos GPT‑OSS fueron refinados usando un proceso muy parecido al que se empleó con o4-mini, que incluye una etapa de ajuste supervisado y otra de aprendizaje por refuerzo (RL) con alta carga computacional. El objetivo principal fue alinearlos con las especificaciones internas de OpenAI y entrenarlos para que aprendan a razonar mediante cadenas de pensamiento (CoT) y a usar herramientas antes de generar una respuesta. Gracias a que se aplicaron las mismas técnicas que en los modelos propietarios más avanzados de OpenAI, estos modelos abiertos muestran un rendimiento destacado tras su entrenamiento final.

Además, al igual que los modelos de la API de OpenAI, gpt-oss-120B y 20B permiten ajustar el nivel de razonamiento (bajo, medio o alto), lo que ofrece un balance entre velocidad de respuesta y profundidad de análisis. Los desarrolladores pueden configurar este comportamiento fácilmente agregando un parámetro llamado “reasoning_effort” en el mensaje del sistema.

Rendimiento de modelos GPT-OSS

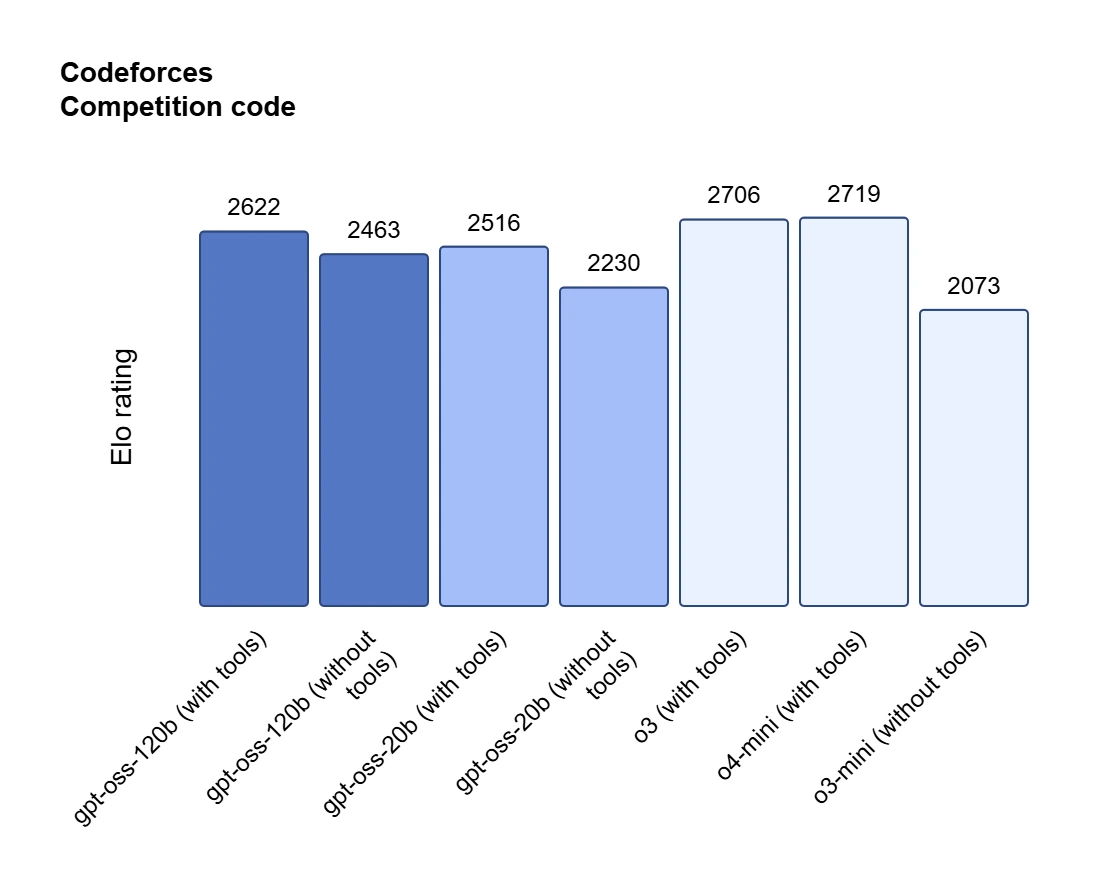

OpenAI asegura que GPT‑OSS‑120B tiene un rendimiento similar a o4-mini, su modelo comercial optimizado para tareas generales. En diferentes benchmarks, ha mostrado resultados competitivos:

| 🧪 Benchmark | 🟢 GPT‑OSS‑20B | 🔵 GPT‑OSS‑120B |

|---|---|---|

| MMLU (conocimiento general) | 51% | 65% |

| AIME (razonamiento matemático) | 39% | 61% |

| Codeforces (código y algoritmos) | 27% | 53% |

| HealthBench (evaluación médica) | 42% | 59% |

Nivel de riesgo de GPT-OSS

OpenAI sometió a los modelos a una serie de pruebas adversariales para asegurar que no presenten riesgos en áreas sensibles como:

-

Biología sintética

-

Ingeniería nuclear

-

Ciberseguridad ofensiva

La conclusión fue que GPT‑OSS no alcanza capacidades peligrosas en estas áreas, y por tanto, su liberación no representa un riesgo inminente, especialmente si se gestiona con buenas prácticas de uso.

¿Cómo puedo usar los nuevos modelos?

Los modelos GPT‑OSS pueden descargarse directamente desde la plataforma de OpenAI o integrarse a través de:

-

Azure AI Foundry (Microsoft)

-

Hardware personalizado (Ej. AMD Ryzen AI Max+)

AMD incluso ha anunciado que el modelo 120B puede ejecutarse a 30 tokens por segundo en su nuevo procesador de 16 núcleos con GPU integrada.

GPT‑OSS vs Otros modelos open-source

| Modelo | Parámetros | Acceso a pesos | Licencia | Requisitos mínimos | Nivel de apertura |

|---|---|---|---|---|---|

| GPT‑OSS‑120B | 117B | ✅ Sí | Apache 2.0 | 80 GB VRAM | Alto |

| LLaMA 3 | 70B | ✅ Sí | Meta license | 48 GB VRAM | Medio |

| Mistral | 12.9B | ✅ Sí | Apache 2.0 | 16 GB RAM | Alto |

| DeepSeek-VL | 20B | ✅ Sí | BSD | 24 GB VRAM | Alto |

Mira el video y conoce más de GPT-OSS

@smart_data 🚀 ¡Llegó GPT-OSS! Después de años OpenAI nos trae un modelo open-source 🙌 Se puede usar y modificar libremente 🛠️💡 Ligero, potente y listo para correr en tu propio hardware 💬 ¿Es el comienzo de una nueva era open source en IA? #gpt #gpt5 #IA #OpenAI #chatgpt #libertadores ♬ sonido original – Smart Data

OpenAI no se queda atrás

Este paso refuerza la creciente competencia global en IA, donde modelos abiertos como Mistral, LLaMA, DeepSeek, o Kimi ya están ganando terreno. OpenAI, que hasta ahora lideraba el mercado con soluciones cerradas, busca con esto reconquistar la comunidad técnica y académica que valora la transparencia, independencia y personalización. El lanzamiento de GPT‑OSS marca una nueva etapa para OpenAI y para el ecosistema de inteligencia artificial. Con estos modelos, cualquier organización puede tener acceso a herramientas potentes, responsables y flexibles sin depender de un proveedor externo. Esto no solo democratiza la tecnología, sino que también invita a repensar el futuro de la IA como un recurso compartido, más accesible y transparente.