NVIDIA en CES 2026: DLSS 4.5, Rubin y el “momento ChatGPT” de la IA física

Jensen Huang subió al escenario del Consumer Electronics Show 2026 (CES 2026) con un mensaje que ya no es solo “más GPUs”: NVIDIA quiere bajar el costo por token, acelerar el razonamiento a gran escala y, de paso, empujar la idea de que la IA deje de vivir solo en pantallas para meterse al mundo físico (autos, robots, fábricas).

@smart_data ¡Adiós Blackwell, hola Rubin! 💎 NVIDIA acaba de presentar su tecnología para el 2026 y es simplemente de otro planeta. 🌍 De juegos a 240 FPS hasta coches autónomos que explican sus decisiones. La frontera entre lo digital y lo físico ha desaparecido. 🤯 ¿Quieres saber qué significa esto para tu bolsillo y para tu PC? 👇 Escribe NVIDIA en los comentarios y te mando la nota completa con todos los puntos clave. 🚀 #NVIDIA #Tech #IA #mercedes #virall ♬ sonido original – Smart Data

La presentación se ordenó alrededor de tres grandes anuncios: DLSS 4.5 para gaming, la plataforma de IA NVIDIA Rubin (con la CPU Vera) para data centers, y Alpamayo, un paquete abierto de modelos y herramientas para autonomía con foco en “razonamiento”.

Indice

ToggleDLSS 4.5: más fluidez “sin regalar” la calidad

Para el público gamer, NVIDIA presentó DLSS 4.5, una actualización grande de su stack de renderizado por IA. El corazón del anuncio fue doble:

- Un Transformer de segunda generación para Super Resolution (la parte que reconstruye imagen a partir de menos píxeles renderizados).

- Y un nuevo enfoque de Multi Frame Generation, con Dynamic Multi Frame Generation y un modo 6X pensado para monitores de alta tasa de refresco.

Según la cobertura técnica, el modo 6X puede generar hasta cinco cuadros adicionales por cada frame renderizado, apuntando a experiencias 4K / 240Hz incluso con path tracing… siempre que estés en hardware compatible (NVIDIA lo asocia a GeForce RTX Serie 50).

¿Qué cambia en la práctica? La apuesta es que el nuevo modelo entienda mejor las escenas y reduzca problemas clásicos de técnicas temporales (ghosting, shimmering, bordes inestables), a la vez que mantiene la fluidez cuando subes el nivel de ray tracing.

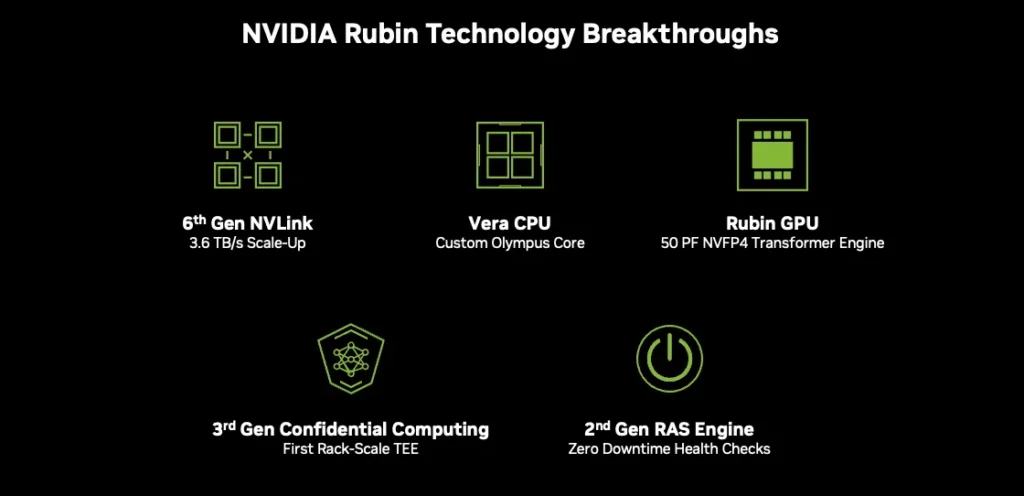

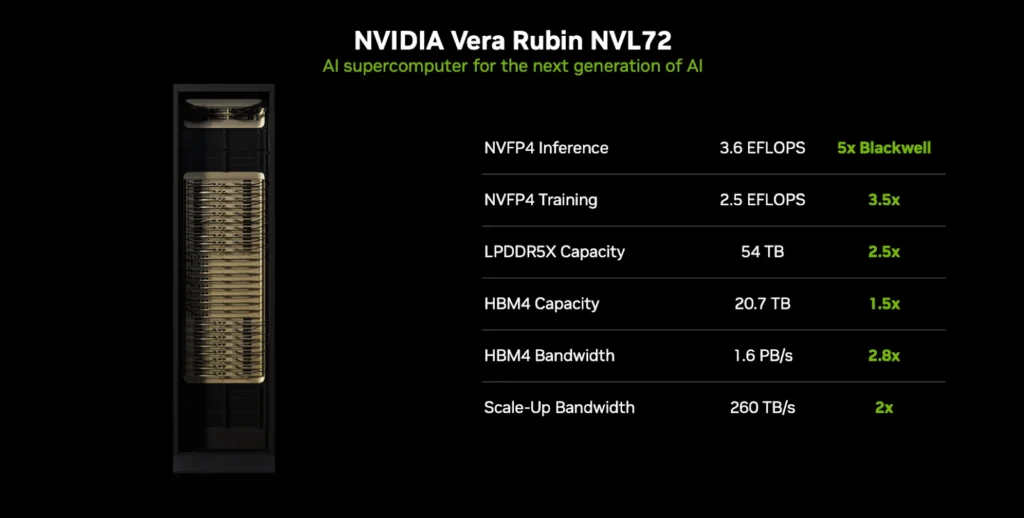

“Vera Rubin”: seis chips, un solo sistema y una promesa agresiva de costo por token

El anuncio más pesado fue NVIDIA Rubin, una plataforma “extreme codesign” (co-diseño extremo) que NVIDIA presenta como un sistema completo, no como piezas sueltas. En su propio resumen del anuncio, Rubin integra seis componentes: Vera CPU, Rubin GPU, NVLink 6 Switch, ConnectX-9 SuperNIC, BlueField-4 DPU y Spectrum-6 Ethernet Switch.

Y aquí está la frase que prende el mercado: NVIDIA afirma que Rubin puede entregar hasta 10x reducción del costo por token de inferencia frente a Blackwell, y entrenar modelos Mixture of Experts (MoE) con 4x menos GPUs (comparación directa contra la plataforma Blackwell).

Huang lo enmarcó como una carrera por velocidad y eficiencia: si entrenas más rápido, llegas antes con la siguiente frontera. Esa narrativa también aparece en el blog oficial del evento, donde NVIDIA insiste en que “esto es time-to-market” y que la plataforma apunta a acelerar innovación bajando el costo de producción de tokens.

Esto ha generado apoyo en el ecosistema Tech de varios CEOs, ¨La plataforma NVIDIA Rubin en AWS representa nuestro compromiso continuo con la entrega de infraestructuras de IA de vanguardia que ofrezcan a los clientes una elección y flexibilidad inigualables. Al combinar la avanzada tecnología de IA de NVIDIA con la escala, seguridad y servicios de IA completos de AWS, los clientes pueden construir, entrenar y desplegar sus aplicaciones de IA más exigentes de forma más rápida y rentable, acelerando su camino desde la experimentación hasta la producción a cualquier escala.», afirma Matt Garman, CEO de AWS

IA física: Alpamayo y la idea de que el auto “razone” antes de actuar

El giro más “futurista pero aterrizado” fue Alpamayo: NVIDIA lo presenta como una familia abierta de modelos, simulación y datasets para acelerar autonomía con foco en el problema duro de siempre: la long tail (casos raros, complejos e impredecibles donde los sistemas fallan).

NVIDIA afirma explícitamente que Alpamayo introduce modelos VLA (Vision-Language-Action) con chain-of-thought para que el sistema pueda pensar paso a paso en escenarios fuera del entrenamiento típico, mejorando capacidad y explicabilidad (clave cuando se habla de seguridad, validación y regulación).

Lo que realmente lo vuelve “paquete” (y no solo un modelo) es esto:

- Alpamayo 1: modelo VLA de razonamiento, con arquitectura de 10B parámetros, liberado con pesos abiertos y scripts de inferencia; NVIDIA lo publica para la comunidad de investigación.

- AlpaSim: framework de simulación open-source para pruebas de alta fidelidad.

- Physical AI Open Datasets: dataset abierto con 1,700+ horas de conducción, buscando cubrir diversidad geográfica y casos raros.

La frase que cerró el concepto fue literal: “El momento ChatGPT para la IA física está aquí… cuando las máquinas comienzan a entender, razonar y actuar en el mundo real”, dijo Huang, conectando robotaxis y autonomía como “los primeros beneficiados”.