¿Cuánta energía y agua usa ChatGPT? Así afecta cada búsqueda en la IA

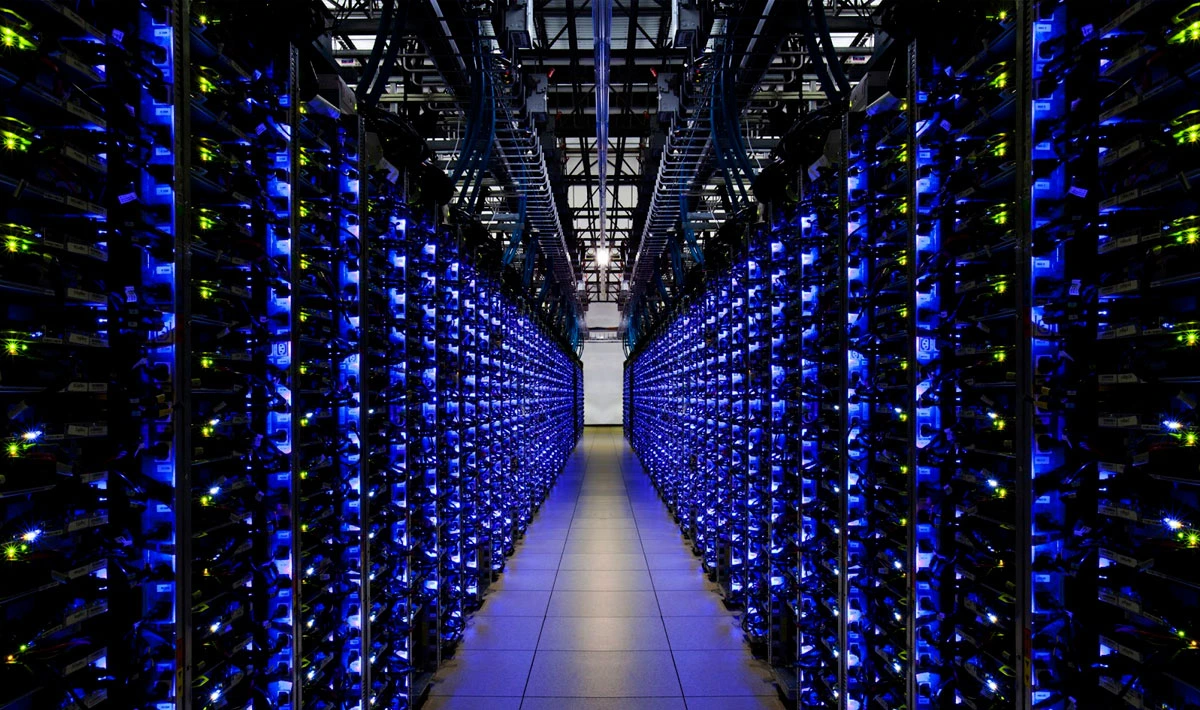

Cuando abrimos ChatGPT para resolver una duda, tras bambalinas se activan miles de chips en centros de datos que consumen electricidad y agua a un ritmo sorprendente. Según un análisis publicado por National Geographic en abril de 2025, generar una respuesta de 100 palabras implica en promedio 0,14 kWh de energía y 519 ml de agua para refrigeración de los servidores, lo equivalente a una botella pequeña de agua.

¿Por qué ocurre?

Este informe indica que si de toda la población estadounidense, solo el 10% usa semanalmente ChatGPT, el consumo de agua anualmente ascendería a más de 435 millones de litros. Esto ocurre por diversos factores:

Calor de los chips

Calor de los chips

Los aceleradores GPU preparan millones de operaciones por segundo. Ese calor debe disiparse: la forma más eficiente es con sistemas de agua junto a torres de enfriamiento o, en climas áridos, aire acondicionado de alto consumo eléctrico.

Electricidad → agua

Cada kilovatio‑hora gastado en computación también genera calor adicional que habrá que enfriar. Es un círculo vicioso: más cálculo, más calor, más agua.

“Razonamiento” = más tokens

Pedir explicaciones largas o código extenso incrementa la cantidad de tokens procesados, multiplicando la huella de recursos.

Obtener una respuesta de 100 palabras equivale a un promedio de 0,14 kilovatios-hora (kWh), suficiente para alimentar 14 bombillas LED durante una hora. Multiplicado por millones de usuarios, el impacto es abrumador. Si solo el 10% de los trabajadores estadounidenses usara esta tecnología semanalmente, el gasto anual de electricidad equivaldría al consumo energético de todos los hogares de Washington, D.C., de más de 600.000 habitantes, durante 20 días.

Cuántos litros y kWh cuesta tu prompt

| Tipo de consulta (= nº de palabras) | Agua usada | Energía usada |

|---|---|---|

| Respuesta breve (20 palabras) | 0,10 L | 0,03 kWh |

| Respuesta estándar (100 palabras) | 0,52 L | 0,14 kWh |

| Ensayo detallado (500 palabras) | 2,60 L | 0,70 kWh |

| Artículo largo (1000 palabras) | 5,19 L | 1,40 kWh |

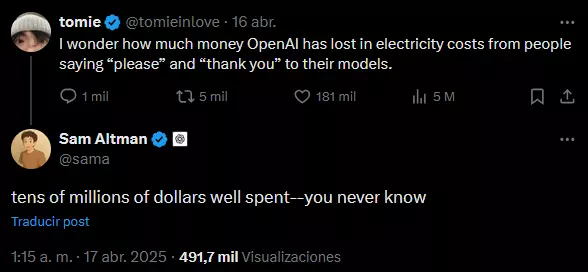

Decirle «por favor» y “gracias” a la IA sale caro

Recientemente, un usuario en redes sociales lanzó una curiosa pregunta al CEO de OpenAI a través de X (antes Twitter) en el cuál puntualiza cuál sería la cantidad que ha perdido OpenAI en electricidad por las veces que la gente dice ‘por favor’ y ‘gracias’ a sus modelos. Sam Altman, CEO de OpenAI, comentó que añadir “por favor” o “gracias” en prompts separados incrementa los tokens procesados y supone “decenas de millones de dólares al año” en cómputo y, por ende, en agua y energía. Ser cortés no es gratis, aunque mejora la naturalidad humana del intercambio.

Medidas que toma OpenAI y sus socios

| Iniciativa | Objetivo |

|---|---|

| Optimización de tokens | Fomentar prompts compactos y reutilizar contexto para reducir inferencias redundantes. |

| Modelos más eficientes | Investigación en distillation y hardware especializado para obtener más rendimiento por vatio. |

| Energía renovable | Contratos con proveedores para abastecer clústeres con energía solar, eólica y proyectos alternativos. |

| Programas de reposición hídrica | Compromisos de reponer agua en cuencas locales para contrarrestar el uso hídrico de los centros de datos. |

| Enfriamiento de circuito cerrado | Pilotos de inmersión líquida sin evaporación que ahorran hasta un 90 % de agua frente a torres abiertas. |

Aprendamos a usar la IA

La próxima vez que charles con ChatGPT, recuerda que cada palabra “bebe” agua y “come” kilovatios. Ser educados está bien, pero ser concisos ayuda al planeta. El reto para OpenAI (y para nosotros) es encontrar el equilibrio entre el poder del razonamiento automático y una huella ambiental sostenible. Optimizar prompts, mejorar hardware y apostar por energías limpias son pasos clave para que la inteligencia artificial no solo sea smart, sino también responsable.